Khám phá các thuật toán trong Machine Learning và cách hoạt động

Thuật toán trong Machine Learning đóng vai trò quan trọng trong việc xử lý và phân tích dữ liệu, giúp tạo ra các mô hình dự đoán chính xác. Để tìm hiểu chi tiết hơn về cách hoạt động của chúng, bạn có thể tham khảo tại Công Nghệ AI, nơi cung cấp thông tin hữu ích về trí tuệ nhân tạo và học máy.

Linear Regression

Hồi quy tuyến tính là một trong các thuật toán trong Machine Learning cơ bản nhất trong thống kê và Machine Learning. Đây là mô hình đơn giản nhưng mạnh mẽ, giúp xác định mối quan hệ giữa biến đầu vào (x) và biến đầu ra (y) thông qua một phương trình tuyến tính. Mục tiêu chính của thuật toán này là tìm các hệ số (B0, B1) sao cho đường thẳng hồi quy mô tả tốt nhất dữ liệu.

Phương trình cơ bản của hồi quy tuyến tính là: y = B0 + B1 * x

Với một giá trị x nhất định, mô hình có thể dự đoán y tương ứng. Để tối ưu hóa mô hình, người ta thường sử dụng các phương pháp như Ordinary Least Squares (OLS) hoặc Gradient Descent nhằm tìm giá trị tối ưu cho các hệ số hồi quy.

Hồi quy tuyến tính trong machine learning đã tồn tại hơn 200 năm và được nghiên cứu rộng rãi. Khi áp dụng thuật toán này, nên loại bỏ các biến có mối tương quan cao để tránh sai lệch trong dự đoán. Đây là một thuật toán đơn giản, dễ triển khai và là lựa chọn lý tưởng cho người mới bắt đầu học Machine Learning.

Logistic Regression

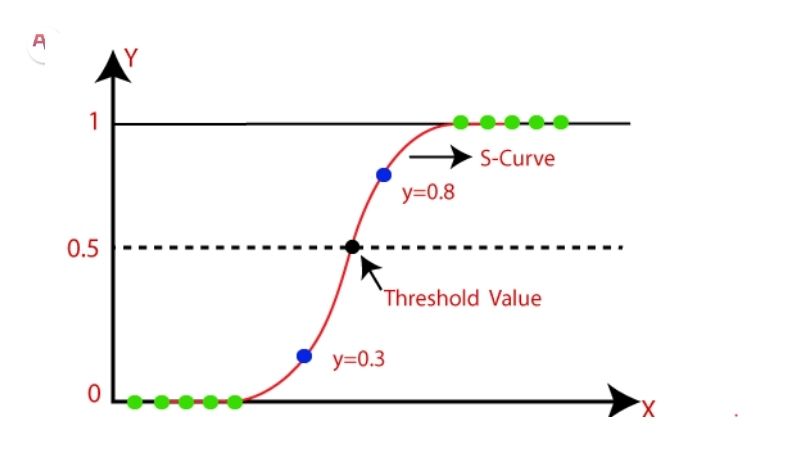

Hồi quy logistic là một thuật toán quan trọng trong Machine Learning, được phát triển từ thống kê và đặc biệt hiệu quả trong các bài toán phân loại nhị phân. Không giống như hồi quy tuyến tính, thuật toán này sử dụng một hàm phi tuyến tính, được gọi là hàm logistic (sigmoid), để biến đổi đầu ra thành một giá trị trong khoảng từ 0 đến 1.

Hàm logistic có dạng hình chữ S, giúp ánh xạ bất kỳ giá trị nào thành xác suất của một đối tượng thuộc về một trong hai lớp. Dựa vào ngưỡng (thường là 0.5), thuật toán sẽ quyết định đối tượng thuộc lớp 0 hay lớp 1. Ví dụ: nếu giá trị dự đoán lớn hơn 0.5, đối tượng được phân vào lớp 1, ngược lại thuộc lớp 0.

Ngoài khả năng phân loại, hồi quy logistic còn cho phép ước tính xác suất của một điểm dữ liệu thuộc về một lớp cụ thể. Điều này rất hữu ích khi cần giải thích và đưa ra quyết định dựa trên nhiều yếu tố.

Tương tự hồi quy tuyến tính, hồi quy logistic đạt hiệu quả tốt nhất khi loại bỏ các biến không liên quan hoặc có sự tương quan cao, giúp mô hình học nhanh và tối ưu hơn trong bài toán phân loại.

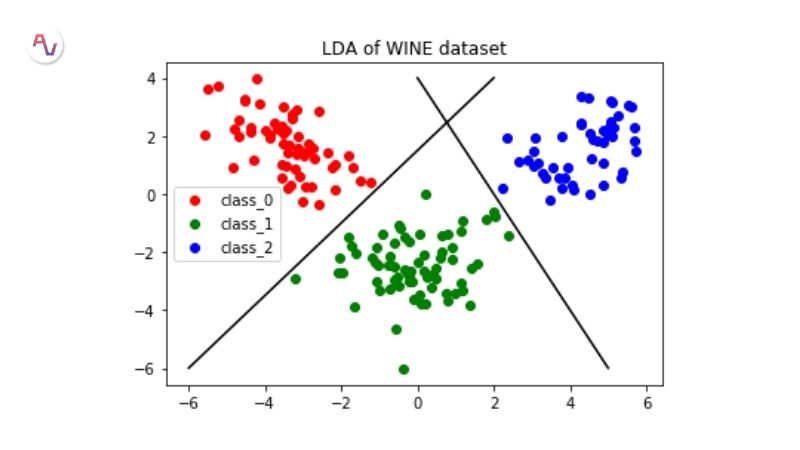

Linear Discriminant Analysis

Hồi quy Logistic là một thuật toán phân loại truyền thống, chủ yếu được sử dụng cho các bài toán phân loại nhị phân. Khi số lượng lớp lớn hơn hai, một phương pháp phù hợp hơn là Phân tích phân biệt tuyến tính (LDA – Linear Discriminant Analysis).

LDA hoạt động dựa trên việc tính toán các thuộc tính thống kê của dữ liệu cho từng lớp. Cụ thể, với mỗi biến đầu vào, thuật toán sẽ xác định:

- Trung bình của từng lớp.

- Phương sai trên toàn bộ tập dữ liệu.

Dự đoán được thực hiện bằng cách tính giá trị phân biệt cho từng lớp, sau đó chọn lớp có giá trị lớn nhất. LDA giả định rằng dữ liệu tuân theo phân phối Gaussian (đường cong hình chuông), do đó, việc loại bỏ các giá trị ngoại vi trước khi huấn luyện mô hình có thể giúp cải thiện hiệu suất.

Nhờ tính đơn giản và mạnh mẽ, LDA trở thành một phương pháp hiệu quả trong các bài toán phân loại. Khi dữ liệu có cấu trúc phù hợp, thuật toán này có thể tạo ra mô hình dự báo chính xác và ổn định.

Thuật toán Machine Learning – Classification and regression trees

Decision Trees (Cây quyết định) là một thuật toán quan trọng trong Machine Learning, được sử dụng phổ biến trong các mô hình dự đoán.

Mô hình này có dạng một cây phân cấp, trong đó mỗi nút (node) đại diện cho một biến đầu vào (x) cùng với một điều kiện phân chia dữ liệu. Nếu biến đầu vào là dạng số, mô hình sẽ đặt một ngưỡng để tách dữ liệu thành hai nhánh.

Dự đoán được thực hiện bằng cách duyệt qua cây, bắt đầu từ gốc và đi qua các nhánh theo điều kiện của từng node, cho đến khi đạt đến nút lá (leaf node). Tại đây, cây quyết định đưa ra giá trị dự đoán của biến đầu ra (y).

Một ưu điểm lớn của Decision Trees là khả năng học nhanh và dự đoán hiệu quả, ngay cả với dữ liệu chưa qua xử lý đặc biệt. Chúng hoạt động tốt trên nhiều loại vấn đề và có thể đưa ra dự đoán chính xác ngay cả khi dữ liệu có sự biến động lớn.

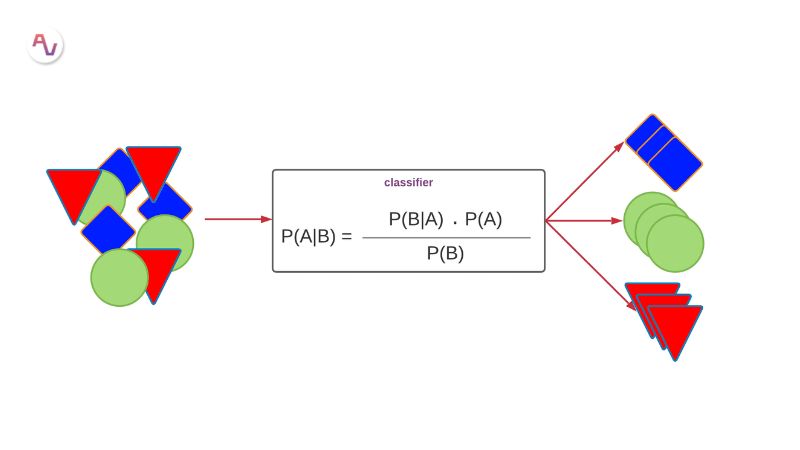

Naive Bayes – thuật toán trong Machine Learning quan trọng

Mô hình này hoạt động dựa trên xác suất thống kê, trong đó có hai loại xác suất chính được tính toán từ dữ liệu:

- Xác suất xuất hiện của mỗi lớp trong tập dữ liệu.

- Xác suất có điều kiện của từng lớp đối với mỗi giá trị của biến đầu vào (x).

Sau khi xác suất được xác định, mô hình áp dụng Định lý Bayes để dự đoán nhãn cho dữ liệu mới. Nếu dữ liệu có giá trị thực, giả định phổ biến nhất là nó tuân theo phân phối Gaussian (đường cong chuông), giúp ước tính xác suất dễ dàng hơn.

Thuật toán được gọi là “Naive” (ngây thơ) vì giả định rằng các biến đầu vào là độc lập với nhau – điều này hiếm khi đúng trong thực tế. Tuy nhiên, bất chấp giả định mạnh mẽ này, Naive Bayes vẫn hoạt động rất tốt trên nhiều loại dữ liệu, đặc biệt là các bài toán phân loại có số lượng đặc trưng lớn và yêu cầu tính toán nhanh.

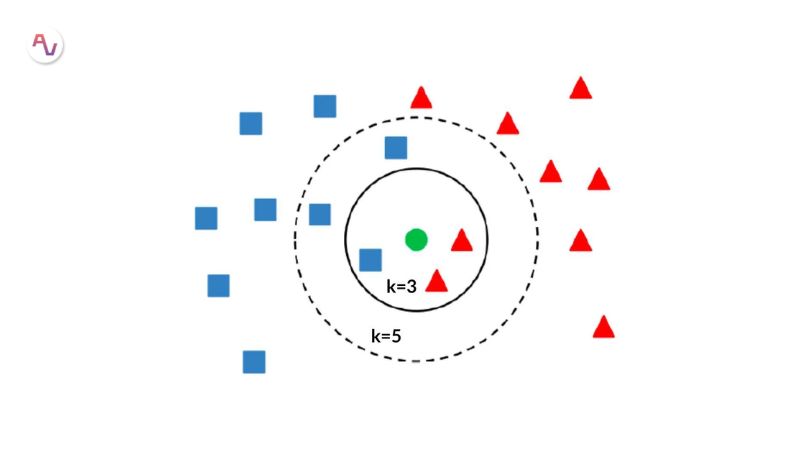

K – Nearest Neighbors – KNN

Mô hình KNN không yêu cầu quá trình huấn luyện phức tạp mà chỉ cần lưu trữ toàn bộ tập dữ liệu. Khi cần dự đoán một điểm mới, thuật toán tìm K điểm gần nhất trong tập dữ liệu huấn luyện, sau đó đưa ra kết quả dựa trên các giá trị của chúng.

Với bài toán hồi quy, đầu ra thường là giá trị trung bình của K điểm gần nhất.

Với bài toán phân loại, thuật toán chọn nhóm có tần suất xuất hiện nhiều nhất (mode).

KNN sử dụng khoảng cách Euclide để đo độ tương đồng giữa các điểm dữ liệu, giúp xác định “hàng xóm” gần nhất. Tuy nhiên, nếu dữ liệu có quá nhiều biến đầu vào, khoảng cách này có thể trở nên kém hiệu quả – hiện tượng này gọi là “lời nguyền của chiều dữ liệu”.

KNN tiêu tốn nhiều bộ nhớ do phải lưu toàn bộ dữ liệu nhưng có thể được tối ưu bằng cách cập nhật và tổ chức lại dữ liệu theo thời gian. Để đạt hiệu quả cao, bạn nên chọn lọc các đặc trưng quan trọng nhất, giúp thuật toán hoạt động nhanh và chính xác hơn.

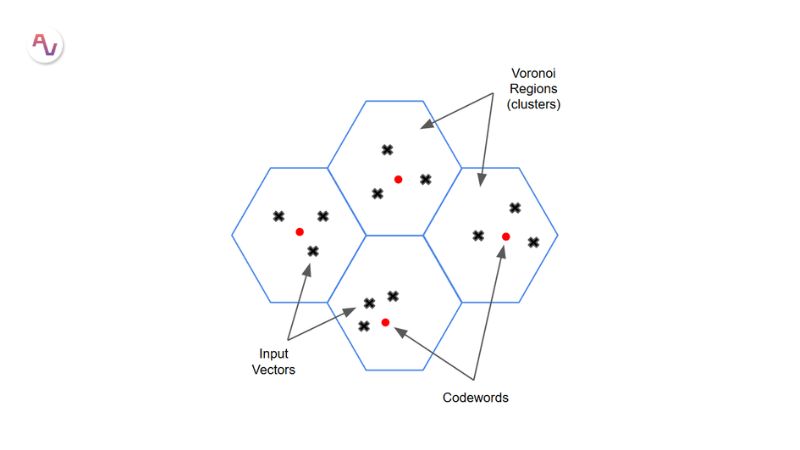

Học Vector Quantization

Một trong những nhược điểm lớn của K-Nearest Neighbors (KNN) là nó yêu cầu lưu trữ toàn bộ tập dữ liệu huấn luyện, làm tăng mức tiêu thụ bộ nhớ. Learning Vector Quantization (LVQ) là một phương pháp mạng thần kinh nhân tạo giúp khắc phục hạn chế này bằng cách tóm tắt dữ liệu thông qua một số lượng điểm đại diện nhất định.

Mô hình LVQ sử dụng một tập hợp các vector mã (codebook vector), được chọn ngẫu nhiên ban đầu và dần điều chỉnh trong quá trình huấn luyện để phản ánh tốt nhất tập dữ liệu. Sau khi huấn luyện, LVQ hoạt động tương tự KNN:

- Dữ liệu mới được phân loại dựa trên vector mã gần nhất.

- Khoảng cách giữa dữ liệu mới và các vector mã được tính toán để tìm giá trị đầu ra phù hợp.

Lợi ích của LVQ

- Giảm yêu cầu bộ nhớ, không cần lưu trữ toàn bộ tập dữ liệu.

- Cải thiện tốc độ dự đoán so với KNN.

- Hiệu quả cao khi dữ liệu đã được chuẩn hóa trong cùng một phạm vi, ví dụ từ 0 đến 1.

Nếu KNN hoạt động tốt trên tập dữ liệu của bạn, hãy cân nhắc LVQ để tối ưu hóa tài nguyên mà vẫn duy trì độ chính xác cao.

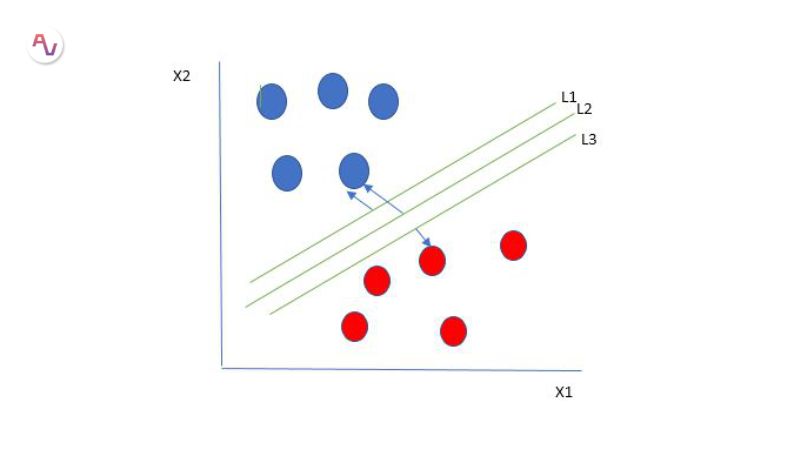

Support Vector machines

Support Vector Machines (SVM) là một trong những thuật toán machine learning phổ biến và mạnh mẽ nhất, thường được sử dụng trong các bài toán phân loại.

SVM sử dụng một hyperplane để phân chia dữ liệu theo từng lớp. Trong không gian hai chiều, hyperplane có thể được hiểu đơn giản là một đường thẳng, tách biệt hai nhóm dữ liệu lớp 0 và lớp 1.

Thuật toán SVM tìm kiếm hyperplane tối ưu – tức là đường phân chia sao cho khoảng cách giữa hyperplane và các điểm dữ liệu gần nhất là lớn nhất. Khoảng cách này được gọi là biên (margin), và mục tiêu của SVM là tối đa hóa biên để đảm bảo phân loại chính xác.

Chỉ một số điểm dữ liệu gần hyperplane mới quyết định cách nó được xác định. Những điểm này được gọi là vector hỗ trợ, vì chúng giúp xây dựng và xác định đường phân chia.

Lợi ích của SVM

- Phân loại mạnh mẽ: Hiệu quả với dữ liệu có cấu trúc rõ ràng.

- Giảm thiểu lỗi: Tối đa hóa biên giúp giảm sai số khi phân loại.

- Ứng dụng machine learning rộng rãi: Dùng trong nhận dạng hình ảnh, phân loại văn bản và nhiều bài toán khác.

Với sức mạnh và độ chính xác cao, SVM là một thuật toán phân loại đáng thử nghiệm trên bất kỳ tập dữ liệu nào!

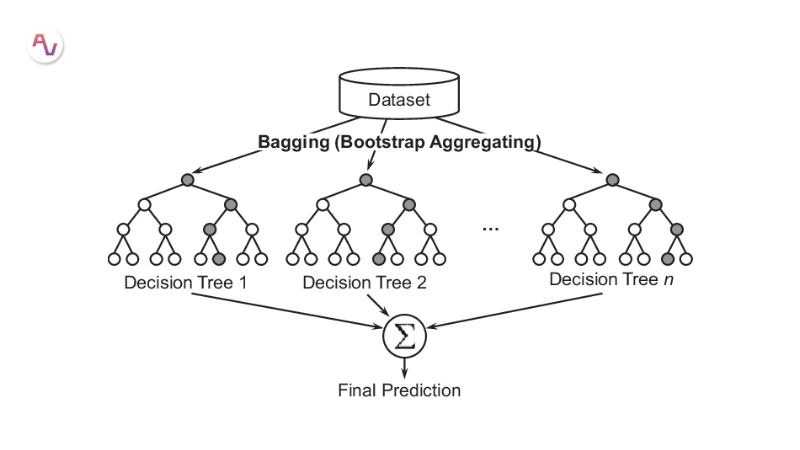

Bagging and Random Forest

Random Forest là một trong những thuật toán machine learning phổ biến và mạnh mẽ nhất, thuộc nhóm Bootstrap Aggregation (Bagging).

Bootstrap là một phương pháp thống kê giúp ước lượng giá trị từ một tập dữ liệu bằng cách lấy nhiều mẫu con, tính toán giá trị trung bình của từng mẫu, rồi tổng hợp kết quả để có một ước lượng chính xác hơn.

Tương tự, trong bagging, thay vì ước lượng một tham số thống kê, thuật toán sẽ xây dựng nhiều mô hình học máy, thường là decision trees. Cụ thể:

- Tập dữ liệu được chia thành nhiều mẫu nhỏ.

- Mỗi mẫu được sử dụng để huấn luyện một decision tree riêng biệt.

- Khi dự đoán, mỗi decision tree sẽ đưa ra kết quả, và kết quả cuối cùng là trung bình của tất cả các dự đoán.

Random Forest cải tiến bagging bằng cách tăng tính ngẫu nhiên trong việc xây dựng decision trees. Thay vì chọn điểm phân chia tối ưu, thuật toán chọn ngẫu nhiên một tập con của các biến đầu vào để tạo cây quyết định.

Điều này giúp mỗi cây có sự khác biệt đáng kể, nhưng khi kết hợp lại, chúng tạo ra một mô hình tổng thể ổn định và chính xác hơn.

Ưu điểm của Random Forest

- Chính xác cao: Giảm overfitting so với decision trees đơn lẻ.

- Tự động xử lý dữ liệu bị thiếu: Ít yêu cầu xử lý trước.

- Làm việc tốt với dữ liệu lớn: Thích hợp cho nhiều loại bài toán phân loại và hồi quy.

Nếu bạn đang sử dụng một thuật toán có độ biến thiên cao như decision trees, thử áp dụng Random Forest có thể giúp cải thiện kết quả đáng kể!

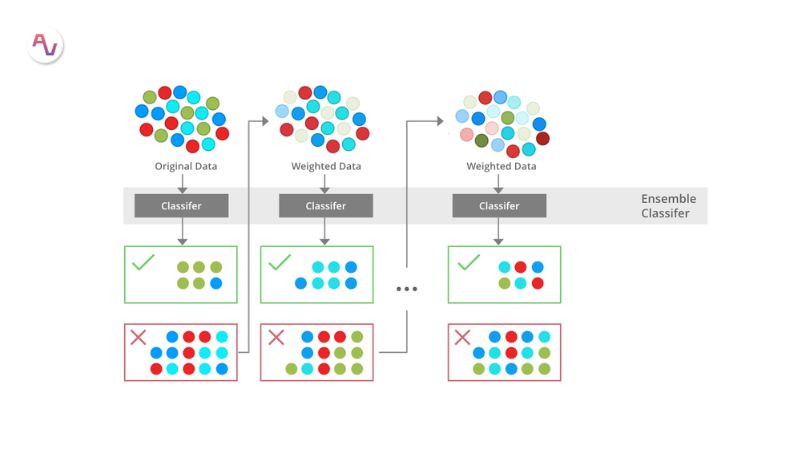

Boosting và AdaBoost

Boosting là một trong các thuật toán cơ bản trong Machine Learning giúp cải thiện độ chính xác của mô hình học máy bằng cách kết hợp nhiều mô hình yếu để tạo thành một mô hình mạnh hơn. Quá trình này diễn ra theo từng bước, trong đó:

- Xây dựng một mô hình cơ bản từ dữ liệu huấn luyện.

- Mô hình tiếp theo được tạo ra để sửa lỗi của mô hình trước đó.

- Quá trình lặp lại cho đến khi đạt được độ chính xác mong muốn hoặc số mô hình tối đa.

Một trong những thuật toán boosting đầu tiên và phổ biến nhất là AdaBoost (Adaptive Boosting), được thiết kế để giải quyết bài toán phân loại nhị phân. Đây là nền tảng quan trọng để hiểu về boosting, và nhiều thuật toán hiện đại như Gradient Boosting Machines (GBM) hay XGBoost được phát triển dựa trên nguyên lý này.

Cách hoạt động của AdaBoost

- AdaBoost thường sử dụng các decision trees đơn giản (weak learners).

- Sau khi mô hình đầu tiên được tạo, thuật toán đánh giá hiệu suất của nó trên từng mẫu dữ liệu.

- Những mẫu khó dự đoán sẽ được gán trọng số cao hơn, buộc mô hình tiếp theo phải tập trung vào những điểm này.

- Các mô hình được xây dựng tuần tự, với trọng số liên tục được điều chỉnh để giảm lỗi.

- Khi tất cả các mô hình đã hoàn tất, dự đoán cuối cùng được tổng hợp từ các mô hình con.

Do AdaBoost tập trung vào sửa lỗi, nó có thể nhạy cảm với dữ liệu nhiễu hoặc outliers. Vì vậy, dữ liệu cần được làm sạch kỹ lưỡng để đảm bảo mô hình đạt hiệu suất tối ưu.

Các thuật toán trong Machine Learning không chỉ giúp tối ưu hóa quy trình xử lý dữ liệu mà còn mở ra nhiều cơ hội ứng dụng trong thực tế, từ nhận diện hình ảnh đến dự đoán xu hướng thị trường. Việc nắm vững các thuật toán này sẽ giúp bạn khai thác tối đa tiềm năng của trí tuệ nhân tạo. Nếu bạn muốn tìm hiểu sâu hơn, hãy truy cập Công Nghệ AI để cập nhật những kiến thức mới nhất về Machine Learning và AI.