Lịch sử phát triển của deep learning (Học sâu) chi tiết

Deep Learning thực sự là một cuộc cách mạng đang thay đổi thế giới. Ẩn sau đó là một lịch sử phát triển của Deep Learning trải dài qua nhiều thập kỷ với những bước tiến vượt bậc và những đóng góp to lớn của các nhà khoa học. Hãy cùng Công Nghệ AI VN tìm hiểu về hành trình đầy thú vị này nhé!.

Lịch sử phát triển của deep learning theo từng cột mốc

Để hiểu rõ hơn về lịch sử phát triển của Deep Learning, chúng ta sẽ cùng nhau đi qua từng cột mốc quan trọng sau đây:

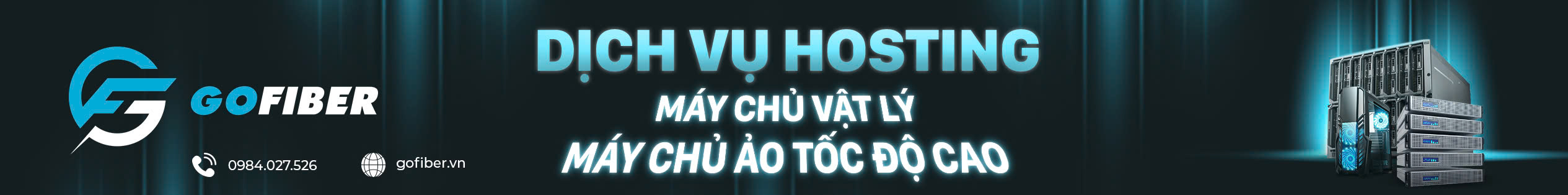

Thập niên 1950 – 1960: Khởi nguồn từ Perceptron

Frank Rosenblatt, một nhà khoa học tài năng, đã giới thiệu Perceptron vào năm 1957. Đây được xem là viên gạch đầu tiên trong lịch sử phát triển của Deep Learning. Mô hình này được xây dựng như một hệ thống đơn giản, mô phỏng cách nơ-ron sinh học xử lý thông tin. Perceptron nhận dữ liệu đầu vào, áp dụng trọng số và tạo ra kết quả phân loại nhị phân thông qua hàm kích hoạt.

Thành tựu này không chỉ gây tiếng vang trong giới học thuật mà còn khơi dậy niềm tin rằng máy tính có thể học hỏi theo cách tương tự con người. Rosenblatt từng dự đoán Perceptron sẽ mở ra kỷ nguyên của máy móc thông minh, một tầm nhìn táo bạo trong bối cảnh công nghệ còn sơ khai.

Tuy nhiên, kỳ vọng sớm bị dập tắt khi Marvin Minsky và Seymour Papert chỉ ra điểm yếu chí mạng của Perceptron trong cuốn sách Perceptrons năm 1969. Mô hình này không thể xử lý các bài toán phi tuyến tính như XOR, một hạn chế khiến cộng đồng nghiên cứu dần mất hứng thú.

Dẫu vậy, thất bại của Perceptron lại mở đường cho ý tưởng về mạng nơ-ron đa lớp (MLP). MLP hứa hẹn vượt qua rào cản của mô hình đơn lớp, dù vào thời điểm đó, việc huấn luyện các mạng sâu hơn vẫn là bài toán chưa có lời giải. Giai đoạn này đặt nền móng đầu tiên cho lịch sử phát triển của Deep Learning, dù còn nhiều chông gai phía trước.

Thập niên 1980: Sự trở lại với MLP và Backpropagation

Sau một thời kỳ im ắng, thập niên 1980 chứng kiến sự hồi sinh của mạng nơ-ron, đưa lịch sử phát triển của Deep Learning bước sang một chương mới. Những tiến bộ trong thuật toán và ứng dụng thực tiễn đã thổi hồn trở lại vào lĩnh vực này. Đặc biệt khi Geoffrey Hinton cùng các cộng sự công bố thuật toán Backpropagation, một bước ngoặt quan trọng trong việc huấn luyện mạng nơ-ron đa lớp.

Mặc dù ý tưởng về backpropagation đã xuất hiện trước đó, nhưng phải đến năm 1986, thì nó mới thực sự được đưa ra ánh sáng. Thuật toán này sử dụng quy tắc chuỗi để lan truyền ngược sai số từ đầu ra về các lớp trước, điều chỉnh trọng số một cách hiệu quả.

Backpropagation đã biến MLP từ lý thuyết thành hiện thực, cho phép các nhà nghiên cứu khám phá tiềm năng của mạng sâu hơn. Sự ra đời của nó không chỉ khắc phục hạn chế cũ mà còn đánh dấu một cột mốc đáng nhớ trong lịch sử phát triển của Deep Learning.

Một trong những minh chứng sớm nhất cho sức mạnh của MLP là LeNet, được Yann LeCun phát triển vào cuối thập niên 1980. Mạng nơ-ron tích chập này tận dụng Backpropagation để nhận diện chữ viết tay với độ chính xác ấn tượng.

Ứng dụng thực tế của LeNet trong việc đọc mã bưu chính và chữ viết trên séc ngân hàng đã chứng minh rằng mạng nơ-ron không chỉ là lý thuyết suông. Thành công này tạo tiền đề cho các ứng dụng phức tạp hơn trong tương lai, khẳng định vai trò của thập niên 1980 trong lịch sử phát triển của Deep Learning.

Thập niên 1990 – đầu 2000: Mùa đông AI và những thách thức

Sau những thành công ban đầu, kỳ vọng vào AI, bao gồm cả mạng nơ-ron, đã trở nên quá cao. Khi những kỳ vọng này không được đáp ứng, sự quan tâm và tài trợ cho nghiên cứu AI đã sụt giảm nghiêm trọng. Các phương pháp AI thời đó, kể cả mạng nơ-ron, vẫn còn nhiều hạn chế khi đối mặt với các bài toán phức tạp trong thế giới thực.

Đồng thời, các phương pháp thay thế như Support Vector Machines tỏ ra vượt trội trong nhiều bài toán, với yêu cầu tính toán thấp hơn. Sự thiếu vắng những đột phá mới cũng góp phần làm giảm sự quan tâm từ cộng đồng khoa học và nguồn tài trợ, đẩy mạng nơ-ron vào bóng tối. Giai đoạn này được gọi là “mùa đông AI” thứ hai, một thời kỳ khó khăn trong lịch sử phát triển của Deep Learning.

Thêm vào đó là máy tính thời đó còn yếu, không đủ sức mạnh để huấn luyện các mạng nơ-ron lớn và sâu. Lượng dữ liệu có sẵn để huấn luyện, đặc biệt là dữ liệu đã được gán nhãn, cũng rất hạn chế.

Những rào cản này khiến các nhà nghiên cứu không thể khai thác hết tiềm năng của mạng sâu. Giai đoạn “Mùa đông AI” là một bài học quý giá trong lịch sử phát triển của Deep Learning, cho thấy tầm quan trọng của công nghệ hỗ trợ và nguồn dữ liệu.

Năm 2006: Khái niệm Deep Learning được khởi xướng

Mọi thứ thay đổi vào năm 2006, khi lịch sử phát triển của Deep Learning đón nhận một làn gió mới. Đây là thời điểm khái niệm “học sâu” chính thức ra đời, mở ra kỷ nguyên hiện đại của trí tuệ nhân tạo.

Khi đó, Geoffrey Hinton và các đồng nghiệp tại Đại học Toronto đã công bố bài báo “A fast learning algorithm for deep belief nets”. Bài báo này giới thiệu Deep Belief Network (DBN), một loại mạng nơ-ron sâu với nhiều lớp ẩn. DBN được huấn luyện theo kiểu “không giám sát” từng lớp một, sử dụng Restricted Boltzmann Machine (RBM). Sau đó, DBN có thể được tinh chỉnh bằng backpropagation với dữ liệu có nhãn.

Công trình của Hinton đã chứng minh rằng các mạng nơ-ron sâu có thể được huấn luyện hiệu quả, vượt qua những khó khăn trước đó. Điều này đã thổi bùng lên ngọn lửa đam mê, đưa lịch sử phát triển của Deep Learning sang một trang mới. Các nhà nghiên cứu bắt đầu khám phá các kiến trúc mạng nơ-ron sâu khác nhau và các kỹ thuật huấn luyện tiên tiến.

Năm 2012: Đột phá với AlexNet và ImageNet

ImageNet Large Scale Visual Recognition Challenge (ILSVRC) là một cuộc thi thường AlexNet, do Alex Krizhevsky, Ilya Sutskever và Geoffrey Hinton phát triển, giành chiến thắng áp đảo trong cuộc thi ImageNet năm 2012. Với độ lỗi top-5 chỉ 15,3%, AlexNet vượt xa các đối thủ sử dụng kỹ thuật truyền thống.

Mạng nơ-ron tích chập này tận dụng ReLU, dropout và sức mạnh của GPU để xử lý hàng triệu hình ảnh. Thành công của AlexNet không chỉ là kỹ thuật mà còn là minh chứng cho sức mạnh của học sâu trong các bài toán thực tế. Nếu nói năm 2006 là khởi đầu, thì năm 2012 là thời khắc Deep Learning thực sự tỏa sáng. Sự kiện này đã thay đổi hoàn toàn cục diện của lịch sử phát triển của Deep Learning và tạo ra một làn sóng mới trong giới khoa học.

Các công ty công nghệ lớn như Google và Facebook nhanh chóng đầu tư vào Deep Learning, trong khi số lượng nghiên cứu về lĩnh vực này tăng vọt. AlexNet chứng minh rằng mạng nơ-ron sâu có thể vượt qua các phương pháp cũ, định hình lại hướng đi của AI. Đây là bước ngoặt quan trọng trong lịch sử phát triển của Deep Learning, mở ra thời kỳ bùng nổ.

Từ 2012 đến nay: Phát triển vượt bậc và ứng dụng rộng rãi

Sau AlexNet, hàng loạt các kiến trúc mạng nơ-ron hiện đại đã ra đời:

- VGGNet (2014) với kiến trúc sâu hơn và sử dụng các bộ lọc nhỏ hơn.

- GoogLeNet (2014) hay Inception, với kiến trúc phức tạp, sử dụng các “inception modules”.

- ResNet (2015) với kiến trúc rất sâu và sử dụng các “residual connections” để giải quyết vấn đề vanishing gradient.

- Ngoài ra, còn có DenseNet, EfficientNet, Transformer, và nhiều kiến trúc khác.

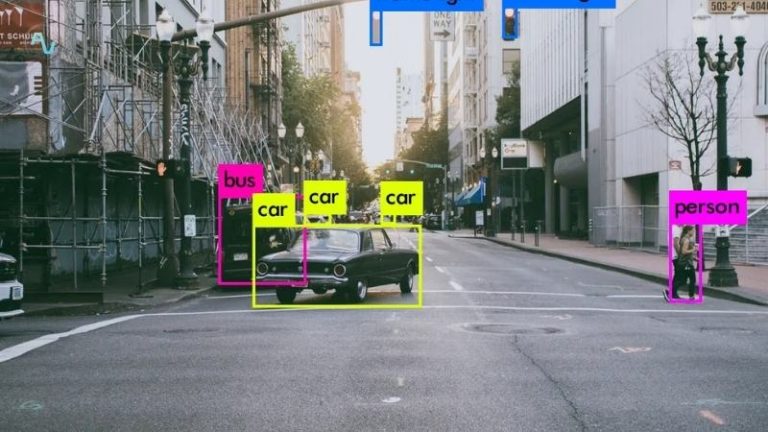

Deep Learning đã và đang được ứng dụng rộng rãi trong nhiều lĩnh vực. Trong thị giác máy tính, nó được sử dụng để nhận dạng khuôn mặt, xe tự lái, phân tích hình ảnh y tế. Trong xử lý ngôn ngữ tự nhiên, Deep Learning được áp dụng cho dịch máy, chatbot, trợ lý ảo.

Trong y tế, nó giúp chẩn đoán bệnh, phát hiện ung thư sớm. Trong tài chính, nó được sử dụng để dự báo thị trường chứng khoán, phát hiện gian lận. Và còn rất nhiều ứng dụng khác trong các lĩnh vực như robot, game, khoa học, nghệ thuật sáng tạo… Lịch sử phát triển của Deep Learning vẫn đang được viết tiếp, với những ứng dụng ngày càng đa dạng và mang tính cách mạng.

Tương lai của học sâu sẽ ra sao?

Các mô hình ngày càng phức tạp đòi hỏi sức mạnh tính toán khổng lồ và dữ liệu đồ sộ. Vấn đề tiêu thụ năng lượng và tác động môi trường cũng trở thành mối quan ngại. Làm sao để Deep Learning trở nên hiệu quả hơn, dễ tiếp cận hơn vẫn là câu hỏi lớn mà các nhà khoa học đang tìm cách giải quyết.

Trong tương lai, Deep Learning có thể là chìa khóa dẫn đến AI tổng quát – hệ thống thông minh toàn diện như con người. Xe tự lái, với sự kết hợp của các mạng nơ-ron sâu, hứa hẹn sẽ trở thành hiện thực phổ biến. Ngoài ra, học sâu có thể mở rộng sang các lĩnh vực như hóa học, giáo dục và hơn thế nữa. Dù còn nhiều thử thách, tiềm năng của nó là vô hạn.

Từ những ý tưởng sơ khai về Perceptron cho đến những mạng nơ-ron khổng lồ ngày nay, Deep Learning đã trải qua một hành trình dài. Mô hình này đã vượt qua nhiều thử thách để trở thành một trong những công nghệ quan trọng nhất của thế kỷ 21.

Với những tiềm năng to lớn và những ứng dụng ngày càng rộng rãi, Deep Learning hứa hẹn sẽ tiếp tục định hình tương lai của trí tuệ nhân tạo và thế giới của chúng ta. Dù tương lai vẫn còn nhiều thử thách, mô hình này chắc chắn sẽ tiếp tục là động lực chính trong cuộc cách mạng trí tuệ nhân tạo. Và có lẽ, những gì chúng ta thấy hôm nay chỉ là khởi đầu của một kỷ nguyên mới.

Nhìn lại lịch sử phát triển của Deep Learning, chúng ta không khỏi kinh ngạc trước những bước tiến vượt bậc mà lĩnh vực này đã đạt được. Từ một ý tưởng trên giấy, nó đã trở thành một công nghệ cốt lõi, len lỏi vào mọi ngóc ngách của cuộc sống. Để tìm hiểu thêm về trí tuệ nhân tạo, bạn hãy nhanh tay truy cập Công Nghệ AI VN để khám phá nhé!